Fizikçilerin gönlünde her dem yer edinen, halkın gündemine de önce Higgs Bozonu’nun bulunması ve yakın zamanda da Higgs Bozonu hakkında daha detaylı bilgi elde edilmesiyle gelen CERN ürettiği yüksek veri miktarı ve bunun yönetilmesiyle ilgili olarak da gündemde.

İki yıllık yenilenmeden sonra iki katına çıkartılan enerji seviyesiyle, Haziran ayında yeniden çalıştırılmasının ardından Avrupa Nükleer Araştırma Merkezi CERN’deki Büyük Hadron Çarpıştırıcısı (LHC) saniyede 3GB veri; yaklaşık olarak yıllık 25 petabayt (25 milyon GB) kaydediyor.

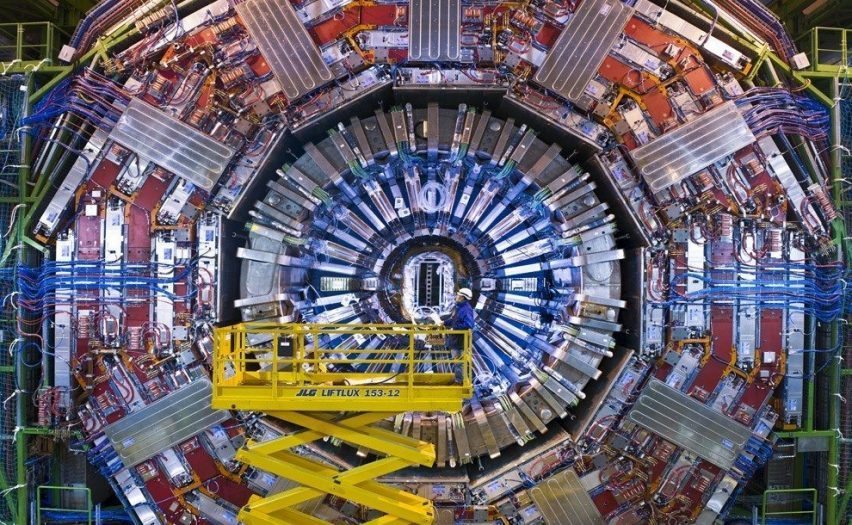

LHC’de, 27 km uzunluğundaki alanda parçacıkları ışık hızına yakın bir hızla her çarpıştırdığında, ayrılan parçacıklar her yöne uçuşmaktadır. Bu parçacıkların uzayda bıraktıkları izler kaydedilmekte ve daha sonra maddenin en basit yapı taşlarını anlamak için incelenmekte ve analiz edilmektedir.

Parçacık çarpışmalarını kaydeden dedektörlerde 100 milyon okuma kanalı mevcut ve saniyede 14 milyon fotoğraf çekebilmekteler. Dolayısıyla, CERN’de üretilen veri miktarı 10 sene öncesine göre oldukça yüksek. Her geçen gün artan veri sebebiyle de CERN neredeyse kurulduğundan beri veri depolama, bulut teknolojileri, veri analizi ve veri güvenliği konularında da ilerlemeye dikkat ediyor. Birden fazla bilgisayarın tek bilgisayar gibi çalışması olarak tanımlanan ‘grid computing’ teknolojisiyle kurulu sistem, elde edilen verinin 42 ülkedeki 170 veri merkezinde 10 binden fazla araştırmacıya ulaştırılmasını sağlıyor. Bu sayede yapılan araştırmaları destekliyor ve 7 Kıtada 10.000’den fazla araştırmacıya hizmet veriyor.

CERN’de parçacık fiziği profesörü Guenther Dissertori, “maddenin en basit parçacıklarını bulmanın samanlıkta iğne aramaktan daha zor” olduğunu dile getiriyor. “Saniyede 14 milyon saman elde ediyoruz ve malesef iğne de samana benziyor” diyor. Veri depolama sorunu da dahil olmak üzere, benzeri teknolojik sıkıntıların CERN ile yapılan kamu ve özel sektör ortak çalışmalarıyla aşılması bekleniyor. Bu da zora meydan okumayı ve ‘samanlıkta iğne bulmayı’ seven veri uzmanları için büyük bir fırsat gibi görünüyor.

Amazon ve Google gibi milyar dolarlık yıllık bütçeye sahip büyük internet şirketlerinin aksine, CERN limitli bir bütçeye sahip; 21 üye ülkeden sağlanan yıllık 1.2 milyar dolarlık bir bütçesi var. Bu sebeple de aranan çözümler sınırlı bütçe dahilinde olmak zorunda.

Yaklaşık 14 yıl önce yüksek veri üretimi sebebiyle CERN veri depolama ihtiyacını öngördü; depolama ve ağ teknolojilerini kendi geliştirdiği OpenLab‘i 2001 yılında açtı. OpenLab; açık kaynak, CERN, kamu ve özel sektör arası ortak çalışmanın ürünü. HP, Intel, Oracle ve Siemens gibi tanınmış şirketler de bu ortaklığın içinde. Bu kapsamda CERN’de mevcut bilişim projeleri ihtiyaç duyulan bilişim teknolojileri altyapılarını içeriyor. Bu projeler; verilerin elde edilmesi, veri depolama mimarisi, programlama platformları, programlama hazırlığı ve yönetimi, ağlar ve iletişim ve veri analizi, başlıkları altında toplanıyor.

Günümüzde LHC ‘grid computing’ kurulu sistemi dahilinde; 132,992 fiziksel işlemci, 553,611 mantıksal işlemci, 300PB online disk kapasitesi ve 230PB manyetik kaset depolama alanı mevcut. Önümüzdeki 10 – 20 yıl içinde hızlandırıcının şiddeti arttırılacağı için, verilerin çok daha büyük bir hızla artması bekleniyor.

Şu anda her LHC deneyi manyetik kasetlere saniyede 500 veri paketi hızıyla kayıt yapıyor ve her bir veri paketi birkaç megabayt veri içeriyor. Ancak CERN, verileri disklerde ya da çevirim içi olarak depolamak istiyor, bu sayede araştırmacılar istedikleri zaman deneyleriyle ilgili verilere ulaşabilecekler. Bu sebeplerle bilişim uzmanları veriyi ekonomik bir şekilde çevirim içi ulaşılabilir yapmak için farklı yollar arıyorlar.

CERN’de yapılan deneylerle ilgili, genelde konudan uzak kişilerce üretilen değişik felaket senaryoları bir yana, bu alanda bilim insanları için gerçek felaket; ilerde hızla artan veriyle baş edemeyip, depolayamama ya da ulaşılır kılamama durumu olabilir. Neyse ki bu konudaki teknolojik gelişmeler de oldukça hızlı ilerliyor.

Kaynak: computerworld, storageservers , CERN